Retour sur un point que j’ai évoqué dans la note précédente. (Et pardon pour ce lamentable jeu de mot.)

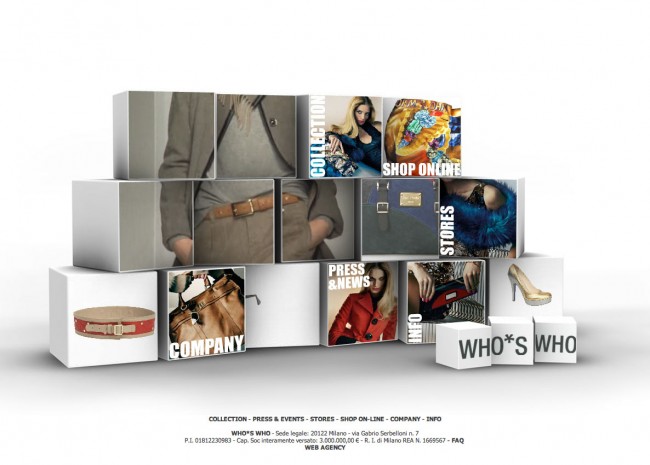

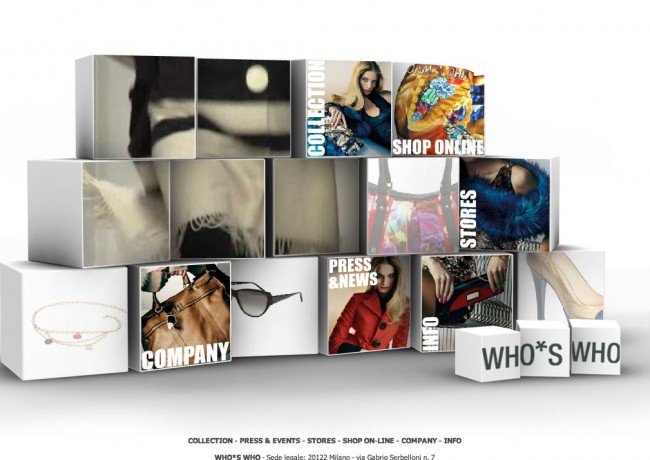

Les concepteurs du site internet de Who*s who ont jugé intéressant d’ajouter de la musique à leur page d’accueil. Cette bande son est apparemment destinée à accompagner le défilé vidéo qui anime la page (ci-dessous, dans les 5 cubes de gauche).

« Lorsque la cliente arrive sur la homepage du site, elle est accueillie par la vidéo d’un défilé et la bande son qui l’accompagne. » Ça, c’est le point de vue des concepteurs. Et c’est effectivement ce qui peut se passer : il est possible que la cliente arrive sur le site et soit accueillie par le défilé et sa musique. (Il est même possible qu’elle aime ça.)

C’est une possibilité. Le problème, c’est qu’il en existe beaucoup d’autres.

• Le son de la machine de l’utilisateur est coupé. Ce n’est pas un drame, c’est même le cas de figure « le moins pire » : le visiteur passera à côté, rien de plus. Les concepteurs seront peut-être tristes d’avoir mis de la musique pour rien (et d’avoir payé les droits d’utilisation le cas échéant), mais ça ne perturbera pas la consultation du site.

Note : c’est ce qui s’est passé lors du test de l’article précédent.

• Le son est activé. L’utilisateur arrive sur le site de Who*s who… et fait profiter tout l’open space du bon vieux tube de Blondie qui se lance automatiquement. Son responsable appréciera sans doute.

Il existe un tas de situations dans lesquelles l’utilisateur ne souhaite pas déranger son entourage avec de la musique. Lui imposer une bande son, c’est prendre le risque (au mieux) de le gêner ou (au pire) de le voir fermer le site à toute vitesse. Ce n’est donc profitable à personne.

• Le son est activé. L’utilisateur, seul à son domicile devant sa machine, arrive sur le site… et coupe hâtivement le son de l’ordinateur, qui lui arrache les tympans.

Il n’est pas possible de connaître à l’avance le volume en mémoire sur la machine de l’utilisateur. S’il s’est envoyé 10 bonnes minutes de Free Bird avant de consulter le site, le volume de sa machine risque d’être particulièrement élevé.

Note : cette remarque est également valable avec « 15 minutes de Pink Floyd ».

• Le son est activé. L’utilisateur, seul à son domicile devant sa machine, n’ayant pas écouté Free Bird il y a quelques instants, arrive sur le site… et coupe précipitamment le son de la machine, en maudissant le concepteur qui lui impose une musique pareille alors qu’il était au beau milieu du légendaire solo de Stairway to heaven.

Il n’est pas possible de savoir si l’utilisateur est en train d’écouter de la musique pendant la consultation d’un site internet. Si c’est le cas, il risque bien de ne pas (du tout) apprécier qu’on lui impose autre chose.

Ajouter du son sur un site internet peut être une très bonne idée… à condition de ne pas oublier deux choses : prévenir l’utilisateur et lui laisser le contrôle. C’est ce qui me semble le plus cavalier de la part des concepteurs du site Who*s who : il n’est même pas possible de couper le son du site ! Et si je coupe le son sur mon ordinateur, il ne sera plus possible d’écouter mon solo de guitare. Heureusement il me reste une solution simple : fermer le site et aller voir ailleurs…